OnCrawl: pierwsze spotkanie z narzędziem do analizy stron on-line

Crawlery, czyli narzędzia do analizy optymalizacji stron internetowych można zgrupować wg tych działających na komputerze lub on-line. Te pierwsze są zasadniczo dużo tańsze, dane zbierają jednak zwykle wyłącznie na komputerze, na którym zostały uruchomione. Te działające jako aplikacje internetowe są znacznie droższe w utrzymaniu, jednak cechują je dość unikalne możliwości, które powodują, że w pewnych zastosowaniach mogą być po prostu efektywniejsze. Jak na tym tle plasuje się francuski OnCrawl?

Jak to działa?

Jako narzędzie dostarczane w formie serwisu (SaaS), OnCrawl nie wymaga właściwie niczego poza przeglądarką internetową. Jest to istotne w przypadku analizy dużych serwisów, gdzie przy kilkudziesięciu, czy kilkuset tysiącach stron, narzędzia desktopowe często przestają pracować w wyniku prozaicznego braku pamięci RAM. 8 czy nawet 16GB bywa niewystarczające przy poważniejszych badaniach. Tutaj oczywiście takiego problemu nie będzie, bo dostajemy narzędzie skalujące zasoby do wykupionego pakietu, gotowe do pracy od razu.

Z drugiej strony należy wspomnieć, że szybkość zbierania danych nie jest powalająca. Testowy projekt o objętości 100 tys. podstron był analizowany przez blisko 35 godzin. Na szczęście nie trzeba w tym czasie mieć uruchomionego komputera, a powiadomienie o zakończeniu badania dostaniemy po prostu na maila ;)

Dla zmaksymalizowania i poprawienia jakości dostępnych danych polecam też od razu integrację raportowania z Google Analytics i Search Console (choć można ją dodać także po wykonaniu samego audytu i dane zostaną zaktualizowane).

Co może OnCrawl?

Obok typowych cech i funkcji dostępnych w podobnych narzędziach, dostaniemy tutaj kilka interesujących możliwości do wykorzystania, szczególnie dla bardziej zaawansowanych w optymalizacji specjalistów.

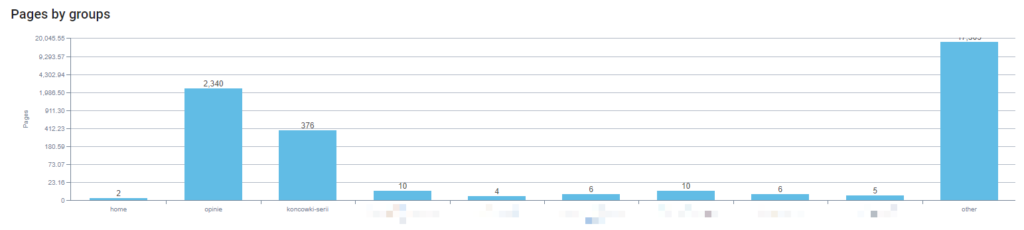

Pierwsze małe zaskoczenie i ciekawostka, to inteligentny, automatyczny podział serwisu na grupy:

Grupowanie podstron w dużych serwisach może być bardzo pomocne. Dostępne w większości raportów pozwala na szybką segmentację problemów wg grup podstron, co ułatwia identyfikację problemów i przygotowywanie rozwiązań.

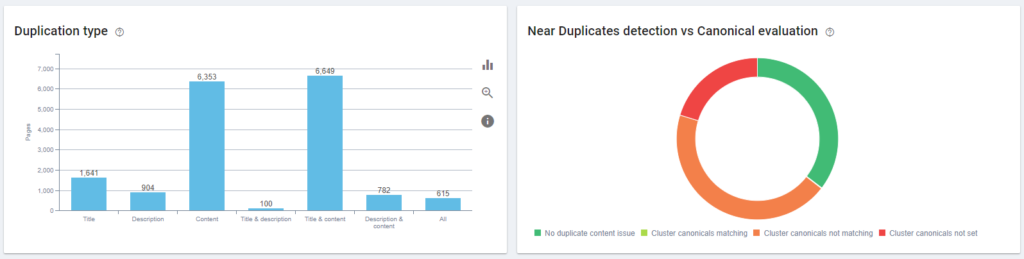

Bardziej użyteczne dane znajdziemy np. w raporcie dot. powielonych treści i podstron.

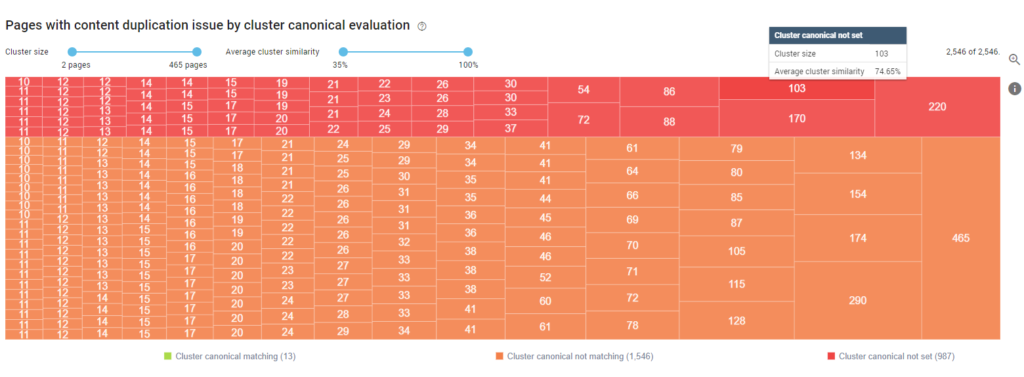

OnCrawl posiada rozbudowane funkcje dedykowane analizie duplikatów, jak i wykrywające strony o treściach bardzo zbliżonych. Pewien obraz potencjalnych problemów dają już podstawowe wykresy:

Pomocna może być też prezentacja wizualna danych o grupach duplikatów, dzięki czemu możemy zacząć od największych grup bardzo zbliżonych treści: A może szukasz indeksowalnych podstron z małą objętością treści? Nic prostszego:

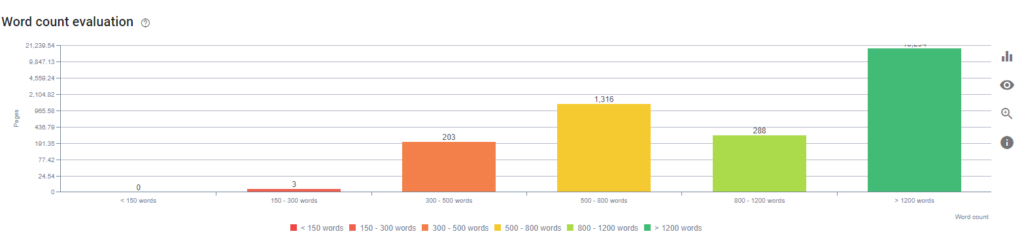

A może szukasz indeksowalnych podstron z małą objętością treści? Nic prostszego:

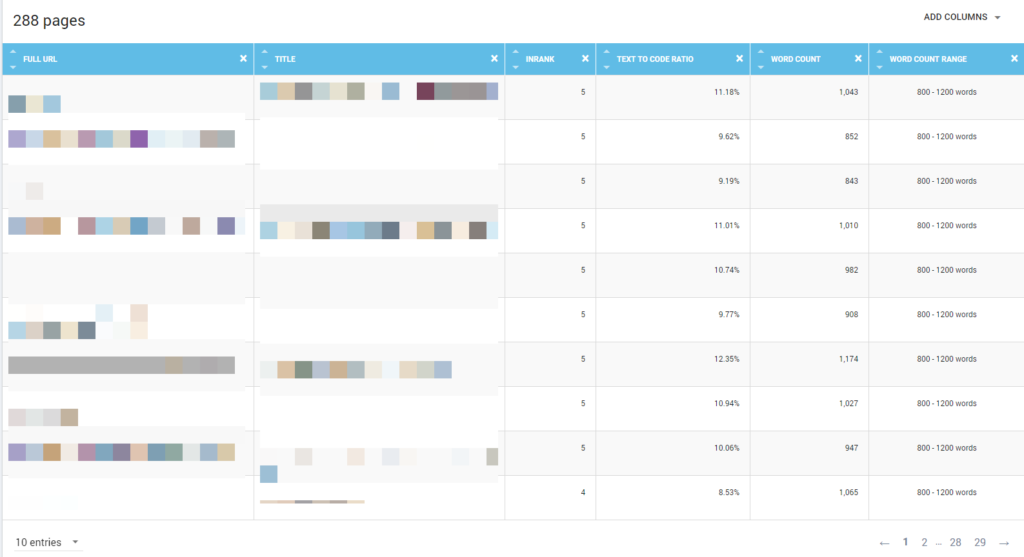

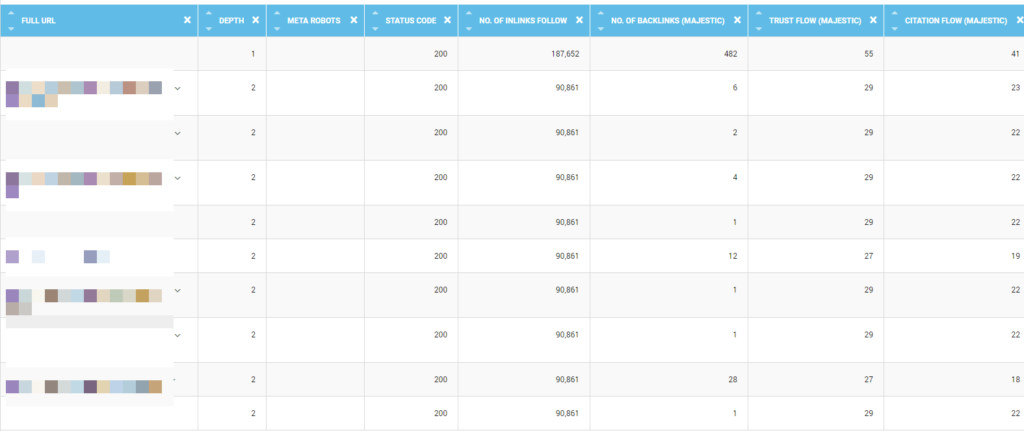

Oczywiście każda kolumna w wykresach prowadzi do szczegółowych raportów z listą podstron i podstawowymi statystykami, co pozwoli znaleźć miejsca wymagające uwagi:

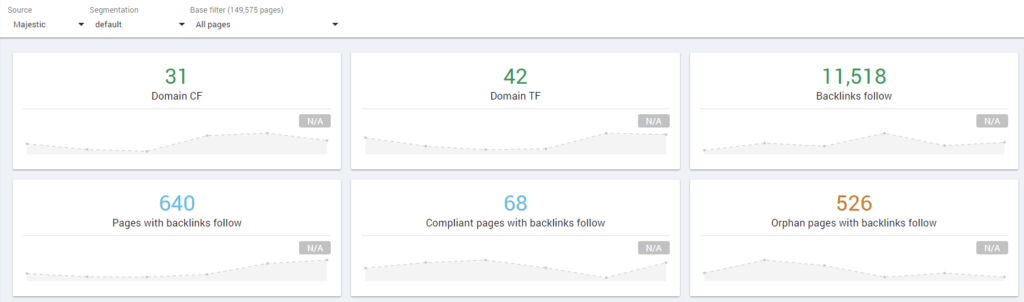

Dość wyjątkowa cecha narzędzia to aktywna analiza linków zewnętrznych. Wykonywana jest w oparciu o dane z FreshIndex zewnętrznego MajesticSEO:

Dane o linkach z Majestic są pobierane bez konieczności posiadania własnego konta, a same statystyki są oczywiście bardzo szczegółowe:

Ile to kosztuje?

Podstawowy pakiet to koszt ok. 150 zł miesięcznie, ale możemy za to utrzymywać tylko 1 projekt. Przy większych ilościach danych koszt wyniesie już sporo ponad 800 zł/m-sc (ale pozwoli to tworzyć i aktualizować do 12 różnych projektów).

To spore kwoty, szczególnie gdy spojrzymy na narzędzia desktopowe tj. lub Sitebulb (126 zł miesięcznie), czy Screaming Frog (60 zł miesięcznie). Z drugiej strony otrzymujemy tu całe mnóstwo bardzo elastycznych, niemal dowolnie konfigurowalnych raportów i zestawień w tabelach (włącznie z opcją importu własnych danych z plików CSV!), dostępnych z dowolnego miejsca na świecie dla dowolnej osoby posiadającej dostęp do konta. To ważne, jeśli przy optymalizacji serwisu pracuje równolegle grupa specjalistów.

OnCrawl jest w stanie pracować także z – tak modnymi ostatnio w świecie SEO – logami serwerowymi (choć niestety wymaga to wykupienia wyższego planu).

Bez wątpienia nie jest to narzędzie dla każdego (albo raczej – nie na każdą kieszeń).

Osiągaj wysokie pozycje w wyszukiwarce, które przełożą się na większą sprzedaż.

Na zachętę dostaniecie 14 dni bezpłatnych testów, co pozwoli zapoznać się z narzędziem jak i samym modelem prezentacji danych.

Polecamy również: