Ostatnie zmiany w Google powodem wolniejszego indeksowania stron?

Ostatni miesiąc obfitował w kilka istotnych zmian wprowadzonych przez Google. W GSC pojawił się nowy raport dotyczący wyników wideo. Została zaktualizowana również nazwa klienta użytkownika Google bota.

To jednak nie wszystko. Wprowadzono także nowe meta tagi typu „nosnippet”, „max-snippet:[numer]”, „max-video-preview:[number]”, „max-image-preview:[setting]”. W GSC pojawiła się nowa opcja świeższych danych w raporcie skuteczności wyszukiwania w Twojej witrynie. Myślę, że najbardziej gorący temat w ostatnim czasie, czyli nowe sposoby identyfikowania charakteru linków – rel=”sponsored”, rel=”ugc”. Postanowiłem zebrać wszystko w jednym miejscu – przy okazji pojawiły się dodatkowe kwestie, które warto omówić. Zapraszam do lektury.

Wyniki wideo

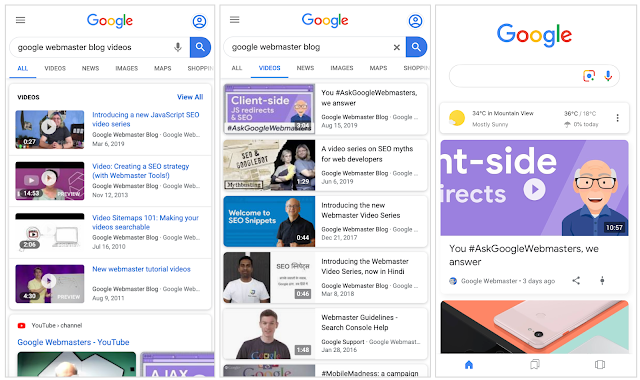

Na stronie https://webmasters.googleblog.com/ czytamy: „Istnieją trzy główne sposoby, w jaki ludzie mogą dziś oglądać filmy w wyszukiwarce Google: na głównej stronie wyszukiwania, na karcie wyszukiwania filmów, i w Discover:

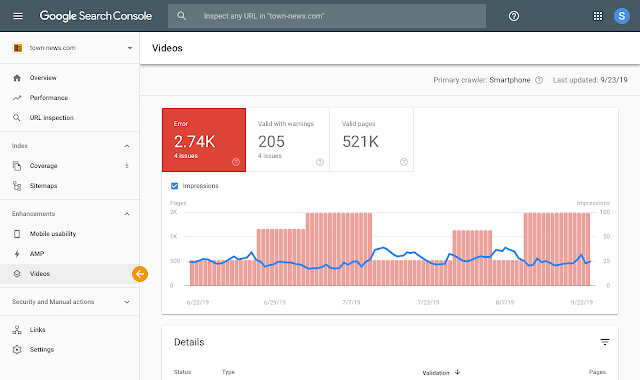

Raport dotyczący ulepszeń wideo zawiera głównie informacje dotyczące implementacji danych strukturalnych bądź ich braku na stronie. W razie wystąpienia problemów, po naniesieniu poprawek, można sprawdzić ponownie stronę i zobaczyć, czy błędy zostały usunięte poprzez przeindeksowanie strony przez bota Google.

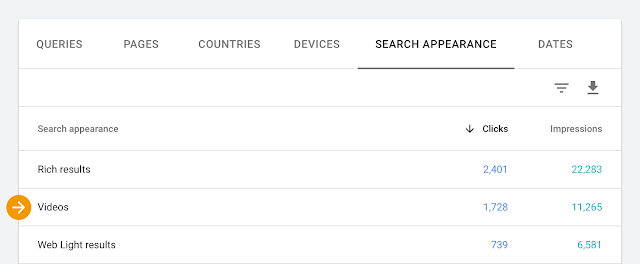

Dodatkowo wystąpienia wideo można znaleźć w raporcie skuteczności.

Google podaje informację, że rozszerzyło obsługę filmów, dzięki czemu można zobaczyć wydajność swoich filmów na głównej karcie wyniki wyszukiwania (type = web) oraz w Discover przy użyciu nowego wyglądu Wideo.

Google jako właściciel największej na świecie wyszukiwarce materiałów wideo (YouTube) wyraźnie dąży do prezentowania użytkownikom w wynikach wyszukiwania jak najbardziej atrakcyjnych treści. Dzięki wdrożeniu pewnego rodzaju standaryzacji, jakim jest opis semantyczny materiałów wideo umieszczanych na stronach dane, video będą mogły być w łatwy sposób skatalogowane, tak jak to miało miejsce obecnie ze standardowym tekstem pisanym na stronach internetowych.

Aktualizacja Google bota

Google do renderowania stron używa przeglądarki Chrome. Na grudzień 2019 zapowiadana jest aktualizacja klienta Google bota, tak by odzwierciedlić nową wersję przeglądarki. Poniżej informacje, jakie zamieścili u siebie na blogu:

Googlebot user agents today

Mobile:

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Desktop:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

OR

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Googlebot/2.1; +http://www.google.com/bot.html) Safari/537.36

The new evergreen Googlebot and its user agent

In December we’ll start periodically updating the above user agent strings to reflect the version of Chrome used in Googlebot. In the following user agent strings, „W.X.Y.Z” will be substituted with the Chrome version we’re using. For example, instead of W.X.Y.Z you’ll see something similar to „76.0.3809.100”. This version number will update on a regular basis.

Mobile:

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Desktop:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

OR

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Googlebot/2.1; +http://www.google.com/bot.html) Chrome/W.X.Y.Z Safari/537.36

Źródło: https://webmasters.googleblog.com/

Jak podaje Google na swoim blogu, zmiany nie powinny wpłynąć na większość witryn internetowych. Witryny stosujące wskazówki i zalecenia publikowane przez Google nie powinny w ogóle tego odczuć. Problem może natomiast dotyczyć stron, które w zależności od user agenta prezentują treść strony.

Do przetestowania swojej strony Google odsyła do tools for web developers: https://developers.google.com/web/tools/chrome-devtools/device-mode/override-user-agent

Aktualizacja Google Bota będzie na 100% wiązała się z przecrawlowaniem indeksu. Możemy się więc w grudniu spodziewać wzmożonej aktywności Google bota na swojej stronie. Po ogłoszeniu informacji ze strony Google z czystej ciekawości sprawdziliśmy logi serwera dla kilku stron i odnotowaliśmy pojedyncze wizyty nowego Google bota, także grudzień może być jedynie datą orientacyjną.

Nowe meta tagi danych strukturalnych

Nie od dziś wiadomo, że Google korzysta z podglądów treści np. fragmentów tekstów czy multimediów ze stron internetowych prezentowanych w wynikach wyszukiwania. Wcześniej można było tylko oznaczyć fragment tekstu i zdecydować, czy zgadzamy się na jego wyświetlanie w wynikach wyszukiwania czy nie. Obecnie wprowadzono kilka znaczników, które pomagają w sterowaniu parametrami, takimi jak maksymalna długość tekstu, czas trwania podglądu video czy maksymalny rozmiar podglądu obrazu.

„nosnippet”

This is an existing option to specify that you don’t want any textual snippet shown for this page.

„max-snippet:[number]”

New! Specify a maximum text-length, in characters, of a snippet for your page.

„max-video-preview:[number]”

New! Specify a maximum duration in seconds of an animated video preview.

„max-image-preview:[setting]”

New! Specify a maximum size of image preview to be shown for images on this page, using either „none”, „standard”, or „large”.

Źródło: https://webmasters.googleblog.com/

Oczywiście znaczniki można łączyć np.:

<meta name=”robots” content=”max-snippet:50, max-image-preview:large”>

Źródło: https://webmasters.googleblog.com/

Można również przypisywać atrybut HTML „data-nosnippet” dla span, div oraz selection, jeżeli nie chcemy, żeby treść strony była wyświetlana w wynikach wyszukiwania. Teraz webmasterzy mają pole do popisu i precyzyjnie mogą oznaczać treści, które mogą zostać wykorzystane przez Google, a które nie.

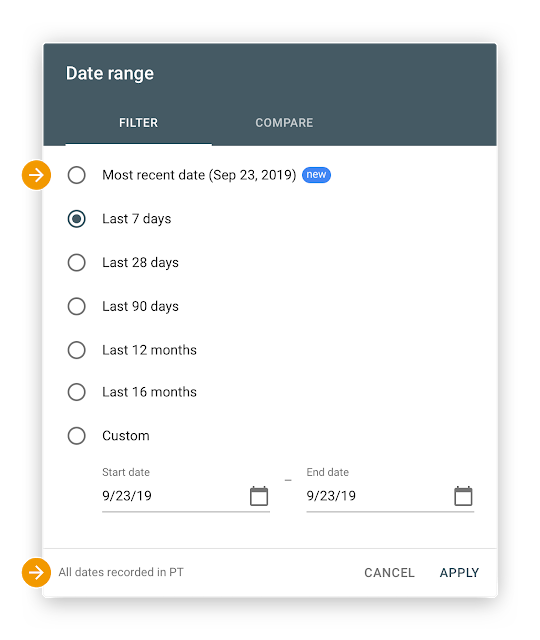

Świeże dane w Google Search Console

Obecnie mamy możliwość przejrzenia danych już z wczoraj w raporcie skuteczności GSC. Jest to ciekawa opcja – myślę, że dla każdego jasna, dlatego nie ma co tutaj się rozpisywać.

W weekendy z aktualizacją danych bywa różnie i np. w niedzielę najświeższe dane mogą być dostępne jedynie z piątku. Przeważnie w poniedziałki dane z soboty i z niedzieli są już dostępne w panelu (Google zadbało o seowców, żeby nie przepracowywali się w weekendy😊).

Nowe znaczniki do identyfikowania charakteru linków

Myślę, że temat nowych znaczników dla oznaczania linków jest najciekawszym z punktu widzenia seowców. Nie ma co owijać w bawełnę, dlatego przejdźmy od razu do konkretów. Google wprowadziło 2 nowe znaczniki do oznaczania linków na stronach rel=”sponsored” i rel = „ugc”. Atrybut rel=”sponsored” służy do oznaczania linków na stronie, które zostały stworzone w ramach reklam, sponsoringu lub innych umów kompensacyjnych. Atrybut rel = „ugc” służy do oznaczania treści generowanych przez użytkowników w obrębie serwisu. Google swoje zmiany tłumaczy tym, że chce lepiej analizować linki umieszczane na stronach. Z punktu widzenia webmasterów i moderatorów forum czy też blogów jest to bardzo wygodne. Poprzez oznaczenie w odpowiedni sposób odpowiednich sekcji serwisów przynajmniej w teorii zminimalizuje prawdopodobieństwo kary za linki wychodzące. W jaki sposób Google traktuje linki, czy uwzględnia je w profilu linków, ile mocy przekazują, czy w ogóle ją przekazują itd… Jeszcze za wcześnie, żeby coś powiedzieć, teoretycznie powinno to działać tak jak nofollow. Jak to wyjdzie w praktyce? Musimy jeszcze poczekać i przeprowadzić kilka testów.

Dlaczego powyższe zmiany wprowadzane przez Google są interesujące?

Wprowadzenie nowego user agenta oraz nowych znaczników kodu html czy też rich snippets, oznaczania materiałów video, obrazków itd. wiąże się z ponownym przecrawlowaniem stron znajdujących się w indeksie.

Ostatnio na jednej z grup SEO zadałem pytanie dotyczące indeksacji. Większość obserwatorów posta nie zauważyła żadnych anomalii. Badania wykonane na świeżych stronach testowych pokazały, że aktywność bota indeksującego w dniach 10.10.2019 – 19.10.2019 była bardzo niska. Od 20.10.2019 obserwujemy wzmożoną aktywność bota indeksującego na nowych testowych stronach. Co w tym takiego ciekawego? Zmiany, o których pisze Google, wpływają na czas indeksacji. Co za tym idzie, jeżeli publikujecie zmiany na stronie klienta i zgłaszacie do reindeksacji, to może to zająć trochę dłużej niż zwykle. Jeżeli pozyskujecie linki do stron, to zanim takie linki „kopną”, też trzeba poczekać, bo witryny, na których są umieszczane, tez potrzebują czasu na reindeksację.

Wnioski nasuwające się po tych wszystkich aktualizacjach są takie, że obecnie cały proces pozycjonowania po raz kolejny robi się jeszcze bardziej skomplikowany i jeszcze bardziej się wydłuży. O ile? Trudno powiedzieć, na razie prowadzimy obserwacje i badamy aktywność botów indeksujących w logach na witrynach testowych i na witrynach, które już kilka lat stoją w sieci i są na bieżąco zasilane świeżymi treściami. Jakieś sensowne wnioski będzie można wyciągnąć po dłuższej obserwacji. Zachęcam do robienia własnych testów i prowadzenia testów, bo to najlepszy sposób na dopasowywanie się do aktualizacji algorytmu.

Osiągaj wysokie pozycje w wyszukiwarce, które przełożą się na większą sprzedaż.

Macie już pierwsze wnioski na temat zmian wprowadzonych przez Google? Zauważyliście aktywność nowego bota? Zapraszam do dyskusji w komentarzach.

Polecamy również: