Lipcowe spadki widoczności. Czy Google każe nam płacić za indeksację stron w wyszukiwarce?

Na przełomie lipca i sierpnia wiele stron straciło część wypracowanej widoczności w wyszukiwarce. Oberwali najwięksi, jak Amazon czy Ebay. Ich, z perspektywy biznesowej, raczej to nie zabolało. Oberwali także duzi jak Answear czy Zalando, i tego typu witryny zapewne już odczuły wpływ aktualizacji na wyniki finansowe. Jednak to dla małych graczy spadki widoczności będą szczególnie niekorzystne. Co było powodem utraty widoczności? Kogo dotknęło owo cięcie i dlaczego niektórych aktualizacja objęła w większym stopniu? Czy można odzyskać utraconą widoczność, a jeśli tak – jak się za to zabrać? Na te pytania postaram się odpowiedzieć w poniższym tekście.

Po pierwsze, trochę danych. Czyli kto i co stracił w lipcu i w sierpniu?

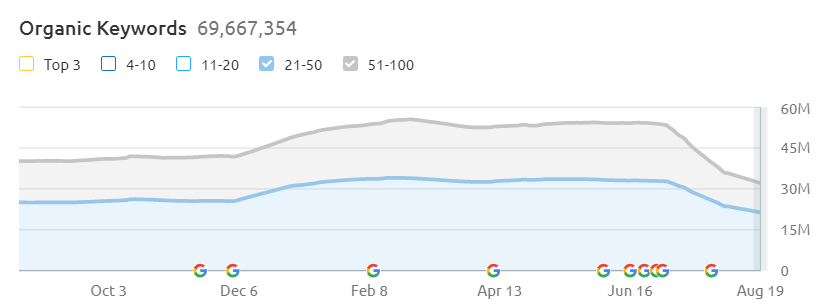

Zacznę od jednej z największych platform sprzedażowych na świecie – ebay.com. Na przełomie lipca i sierpnia witryna utraciła część swojej ogólnej widoczności – wykres poniżej.

Na grafice prezentuję widoczność strony dla fraz na pozycjach od 21 do 50 i od 51 do 100. Na tych pozycjach zazwyczaj indeksują się frazy z tzw. długiego ogona. Tutaj domena straciła najwięcej, a liczba fraz w TOP3 i w TOP10 także zmalała. Jednak zarówno utrata pozycji w pierwszej dziesiątce wyników, jak również spadek ilości zapytań generujących ruch dla fraz na pozycjach 11-20 nie był tak dotkliwy, jak właśnie dla słów luźno powiązanych z tematyką poszczególnych podstron.

Z początkiem lipca domena ebay.com osiągała widoczność na poziomie około 52-53 milionów fraz. Z dniem pisania artykułu, tj. 20 sierpnia 2021 roku, domena jest widoczna pod 32 milionami fraz! To spadek o ponad 20 milionów słów kluczowych!

Moim zdaniem obcięcie widoczności dotyczyło głównie zapytań niepowiązanych bezpośrednio z tematem danego adresu url – spadła widoczność na wszelkie frazy, na które witryna wyświetlała się dodatkowo, bo gdzieś w treści pojawił się dany zwrot.

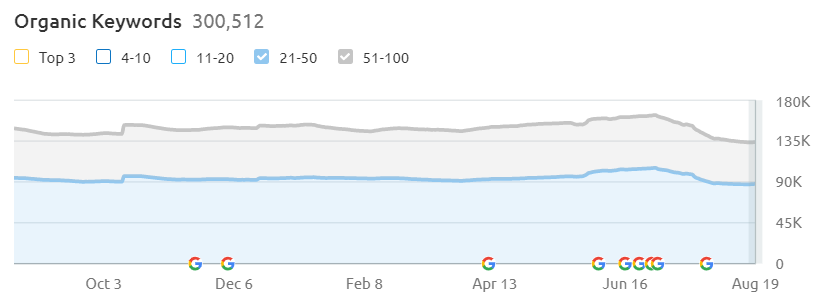

Podobnie jest w przypadku witryny amazon.com. Tutaj także ogólna widoczność strony spadła z 93,5 miliona z początkiem lipca do poziomu 65,5 milionów fraz, na które domena wyświetla się z dniem 20.08.

I podobnie, jak w przypadku witryny ebay.com, Amazon także stracił widoczność głównie na frazach z pozycji 21-100. Strona na słowa kluczowe, na które wyświetlała się wyżej, w większej mierze pozostała na swoim miejscu.

Search Engine Journal informował, że lipcowa aktualizacja to ciąg dalszy aktualizacji czerwcowej. Co więcej, pomiędzy czerwcowym a lipcowym update’em miała miejsce jeszcze aktualizacja dotycząca spamu w sieci oraz uruchomienie aktualizacji dotyczącej Page Experience.

O powodach spadków

Większość specjalistów SEO taki stan rzeczy argumentuje aktualizacją dotyczącą linkowania. Powodów szukają także w brakach odpowiedniego oznaczania pozyskiwanych linków. W zeszłym roku Google informowało o konieczności oznaczania backlinków tagiem sponsored w przypadku odnośników umieszczonych w opłaconych artykułach oraz tagiem ugc w przypadku linków z sekcji user generated content (treści tworzonej przez użytkowników). Miało to zastąpić tag nofollow, który obecnie jest już tylko wskazówką a nie instrukcją dla robotów.

Moim jednak zdaniem powyżej zaprezentowane spadki widoczności mogą być także spowodowane aktualizacją dotyczącą treści na witrynach. Nie neguję argumentacji, że za spadki widoczności odpowiada SPAM update z 23 i 28 czerwca br. Za tą tezą może przemawiać m.in. dwukrotna zmiana trendu widoczności poniekąd pokrywająca się datami z aktualizacją związaną z linkami.

Jednak biorąc pod uwagę fakt, że portale newsowe czy duże portale aukcyjne raczej nie pozyskują linków zewnętrznych, a przynajmniej nie w ilości, która miałaby taki wpływ na widoczność, SPAM update może nie być jedynym wytłumaczeniem.

Dlatego o ile w pewnym stopniu zgadzam się, że aktualizacja obcinająca widoczność stron dla fraz, na które pozycjonowano witryny linkami z mniej wartościowych miejsc czy z artykułów, w których linków nie opisano odpowiednim tagiem, o tyle uważam także, że na spadki mogła mieć wpływ również aktualizacja związana z treściami z czerwca oraz z lipca tego roku.

Spadki na polskim podwórku

W Polsce aktualizację odczuli m.in. Zalando i Answear.com. W przypadku tego pierwszego mówimy o utracie widoczności z poziomu 160 tysięcy fraz do poziomu 133 tysięcy, natomiast Answear.com spadł ze 113 tysięcy fraz do 83 tysięcy słów kluczowych, na które wyświetlał się w Google. Poniżej widzimy wykres dotyczący Zalando.

Podobne spadki zauważamy także u klientów, u których obok działań skupionych stricte wokół ich oferty, prowadziliśmy także kampanię poświęconą długiemu ogonowi. Domeny, które posiadają aktywnego bloga, straciły na widoczności właśnie na frazach długoogonowych.

Jest to przede wszystkim problem witryn o wąskiej ofercie, gdzie dopiero marketing treści z wykorzystaniem bloga, pozwala na dotarcie do szerszego grona potencjalnych klientów. Drugą kategorią witryn, u których dostrzec można spore spadki, są sklepy internetowe z bardzo obszerną ofertą. W tego typu witrynach często podstrony popularnych kategorii produktów indeksują się na wiele fraz kluczowych luźno powiązanych z frazą główną.

Jeśli chodzi o biznesy, w których konieczne jest wykorzystanie bloga, przez operowanie w jakiejś niszy bądź przez wąski zakres usług, niemal niemożliwym jest wypozycjonowanie się wyłącznie na kilka bardziej ogólnych fraz. Natomiast walka na słowa o niższym wolumenie wyszukań, biorąc pod uwagę obecne koszty pozycjonowania, mogą się nie zwracać. SEO w takim wypadku może przestać być opłacalne.

Sklepy internetowe z obszerną ofertą stracą na ogólnej widoczności, ale ich przychody nie powinny znacząco zmaleć. Google obcina widoczność na frazy, które i tak raczej nie generują sprzedaży.

Jak teraz pozycjonować strony z małą ilością podstron?

I co dalej z długim ogonem? Czy ta strategia jest już spalona? Czy dotychczasowe praktyki przestaną działać? Zapewne nie. Długi ogon nadal powinien spełniać swoje zadanie, natomiast wydaje mi się, że należy bardziej przykładać się do researchu fraz kluczowych. Może być tak, że treści planowane na bloga powinny w większej mierze dotyczyć oferowanych usług. Rozdrabnianie się na najmniejsze elementy może nie przyczynić się do zwiększenia ruchu.

Tekst przygotowany pod frazy ledwie dotykające głównego tematu poruszanego w obrębie całej domeny może nawet nie zostać zaindeksowany. Dlatego być może w przyszłości trzeba będzie zastanowić się nad wstrzymaniem działań contentowych dla niektórych projektów, zwłaszcza, jeśli ze strony wyszukiwarki będzie silny opór przed indeksowaniem nowych treści blogowych.

Co moim zdaniem było powodem obcięcia widoczności?

Wydaje mi się, że decyzja o obcięciu widoczności stron na tzw. long tail jest nieco powiązana z aktualizacją dotyczącą Page Experience i pozornej troski Google’a o ekologię. Pracownicy Google’a aktualizację dotyczącą Core Web Vitals argumentowali troską o środowisko. Sieć, jaką znamy obecnie, wymaga od Google’a posiadania wielu różnych Data Center (serwerowni), w których gromadzone są dane potrzebne do prezentowania wyników w wyszukiwarce. Owe serwerownie wymagają prądu, chłodzenia i nadzoru człowieka.

Pracownicy Google’a stwierdzili, że zadbanie o nasze strony z perspektywy prędkości ładowania pozwoli na utrzymanie infrastruktury wyszukiwarki w obecnym stanie, co będzie miało pozytywny wpływ na środowisko. Mniejsze zużycie procesorów, mniej wydatków na chłodzenie pomieszczeń.Mniej usterek.

W przeciwnym razie Google będzie zmuszone rozbudowywać swoją infrastrukturę, co przyczyni się do większego zapotrzebowania m.in. na energię elektryczną.

Moim zdaniem prawda leży gdzieś pośrodku. Wydaje mi się, że jak zwykle chodzi o pieniądze. Pandemiczny napływ nowych biznesów do sieci spowodował masową liczbę zgłoszeń nowych stron do indeksacji. Już z końcem ubiegłego roku Google miał problem z przetworzeniem takiej ilości danych i zablokował możliwość ręcznego zgłaszania nowych podstron do indeksacji. Obok tego, na rynku pracy byliśmy i nadal jesteśmy świadkami po pierwsze – wysypu ofert pracy w charakterze specjalisty ds. SEO, po drugie – braku tychże specjalistów.

Wszystkie sygnały wskazują na jedno: pozycjonowanie stało się modną praktyką w marketingu internetowym. Zwłaszcza w otoczeniu coraz niższych organicznych zasięgów w social mediach.

Pracownicy Google’a także są tego świadomi i chcąc umożliwić indeksację stron nowym biznesom, muszą znaleźć dla nich miejsce. Mogą albo zbudować kolejne serwerownie, które pozwolą obsłużyć dopiero co zarejestrowane domeny, albo zrobić miejsce na fizycznych dyskach już istniejących serwerów. To rozwiązanie znacznie tańsze i prostsze, dlatego według mnie, właśnie na przełomie lipca i sierpnia byliśmy świadkami czyszczenia powierzchni serwerowych pod indeksację nowych adresów. Nie wiem, czy powodem była aktualizacja dotycząca linków czy treści, ale prawdą jest, że musimy zadbać m.in. o te dwa aspekty w jeszcze większym stopniu niż wcześniej.

Dlaczego jedni oberwali, a inni nie?

Tak jak pisałem wcześniej, wygląda na to, że Google postanowiło obciąć widoczność z długiego ogona. To znaczy, że biznesy, które nie opierały się w większej mierze na tej strategii, nie straciły tyle, co witryny wykorzystujące tę strategię w kampanii pozycjonowania.

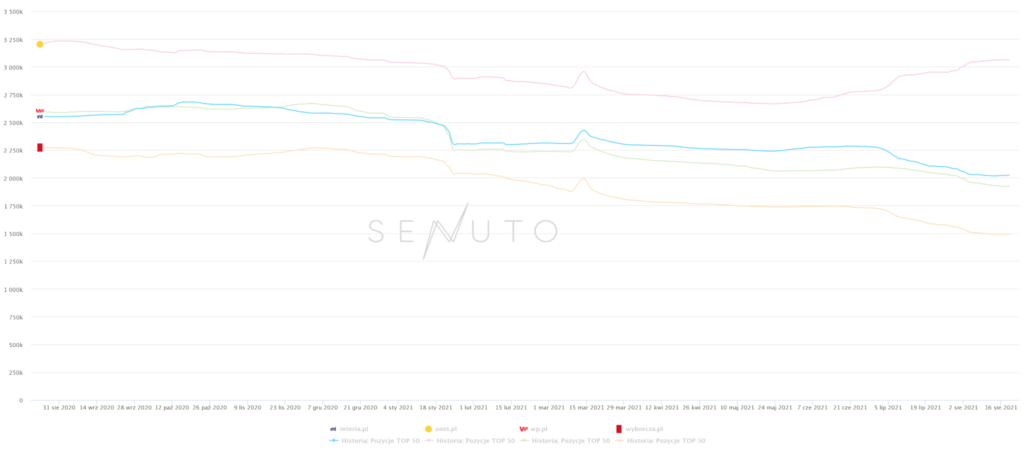

Co ciekawe, na widoczności straciły również niektóre portale newsowe, zwłaszcza te, działające na subdomenach: Interia, Wp, Wyborcza. Zyskał natomiast Onet.

Jaka jest różnica między tymi stronami? Otóż Onet, w przeciwieństwie do Interii, Wp czy Wyborczej wykorzystuje osobne domeny do poruszania poszczególnych tematów. Stosowanie osobnych domen, a nie subdomen, pozwoliło utrzymać Onetowi tematykę danej witryny, przez co Google nie potraktował ich jako całości.

Wydaje mi się, że powyższy wykres to kolejne potwierdzenie teorii, dotyczącej obcinania widoczności na frazy luźno powiązane z głównym tematem domeny. Być może właśnie odejście od subdomen na rzecz osobnych witryn, jeśli dana tematyka jest zgoła inna od pozostałych treści, poruszanych w innych miejscach domeny czy nawet na innych subdomenach, może być rozwiązaniem dla naprawdę dużych graczy. Należy mieć jednak na względzie konieczność przeindeksowania starych adresów na nowe, a biorąc pod uwagę obecny trend na pozycjonowanie i marketing w sieci, potrwa to znacznie dłużej niż przed pandemią.

Co zrobić w przypadku utraty widoczności?

Moim zdaniem jedynym rozwiązaniem jest przeredagowanie treści, które straciły na widoczności i ponowna indeksacja na frazy bardziej powiązane z głównym tematem witryny. Ewentualnie wyłączenie z indeksowania podstron, które są skierowane do odbiorców już kojarzących markę i trafiających na stronę przez inne kanały pozyskania ruchu, jak social media czy newsletter.

Tworzenie i celowe indeksowanie w wyszukiwarce treści dotyczących branży, ale nie mających na celu pozyskiwanie ruchu z Google’a, może negatywnie wpłynąć na widoczność strony. Google uzna, że należy wyindeksować podstrony zoptymalizowane na frazy wartościowe i zaindeksować nowe podstrony, które nie przekonają nowych odbiorców do zakupu produktu czy usługi.

Oczywiście gdzieś obok nadal musimy walczyć o linki prowadzące do strony, ale teraz będziemy musieli jeszcze bardziej starać się o ich jakość. Docieramy do chwili, w której zaplecza powinny być nie tylko atrakcyjne pod kątem profilu linkowego, ale także jakości znajdującej się na nich treści. Być może warto rozważyć tworzenie pełnoprawnych portali tematycznych, żywych, poruszających tematy faktycznie interesujące człowieka.

Osiągaj wysokie pozycje w wyszukiwarce, które przełożą się na większą sprzedaż.

Moim zdaniem nadszedł czas restrykcyjnego SEO, gdzie będzie kładziony nacisk nie tylko na jakość treści i konstrukcję witryny, ale także ilość podstron w obrębie danej domeny. Kto wie, być może w niedalekiej przyszłości właściciele stron będa musieli płacić abonament wyszukiwarce, za możliwość zaindeksowania większej liczby podstron? Wtedy o istnieniu w wyszukiwarce naprawdę będzie decydował portfel.

Polecamy również: